Wprowadzenie: Imperatyw zarządzania AI dla liderów C-level

Uznanie obaw kadry kierowniczej wobec ryzyk związanych ze sztuczną inteligencją i rosnącej złożoności regulacyjnej

Dynamiczny rozwój technologii AI niewątpliwie przyciągnął uwagę kadry zarządzającej najwyższego szczebla w różnych branżach. Choć wielu dostrzega transformacyjny potencjał sztucznej inteligencji, znacząca część wyraża uzasadnione obawy dotyczące jej ryzyk. Obawy te nie są abstrakcyjne – wynikają z namacalnych zagrożeń biznesowych, w tym możliwości popełniania błędów i tzw. „halucynacji” przez AI, zwiększonego ryzyka naruszeń prywatności lub wycieków danych, a także poważnej odpowiedzialności prawnej i finansowej w przypadku niewłaściwego wykorzystania sztucznej inteligencji. Takie ryzyka bezpośrednio wpływają na ciągłość działania organizacji, jej efektywność operacyjną oraz – co kluczowe – reputację marki.

Istnieje zauważalna rozbieżność między pewnością, jaką kadra C-level deklaruje wobec swoich systemów AI, a faktyczną dojrzałością mechanizmów zarządzania w organizacjach. Pomimo że aż 72% liderów raportuje wdrożenie i skalowanie AI w ramach różnych inicjatyw, jedynie jedna trzecia firm posiada odpowiednie procedury zgodne z zasadami odpowiedzialnej sztucznej inteligencji. Ta luka stanowi poważną podatność, którą mają adresować ramy regulacyjne. Obawy menedżerów wobec AI często są racjonalną reakcją na policzalne ryzyka biznesowe. Dlatego niniejszy raport przedstawia regulacje AI nie jako dodatkowe obciążenie, lecz jako strategiczne narzędzie minimalizacji ryzyka i ochrony biznesu – odpowiadające na kluczowe kwestie odpowiedzialności, kar finansowych i bezpieczeństwa danych. Zrozumienie niuansów regulacyjnych może przekształcić AI z postrzeganego zagrożenia w odpowiedzialnie zarządzany zasób.

Nakreślenie sceny: Dlaczego zrozumienie globalnych regulacji AI jest kluczowe dla strategicznego podejmowania decyzji

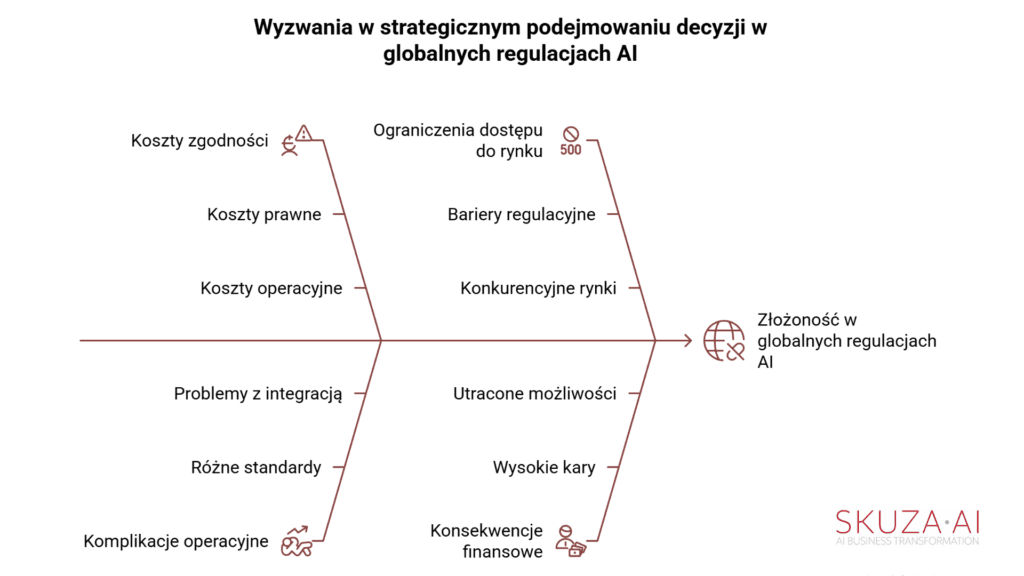

Dla przedsiębiorstw globalnych filozoficzne i praktyczne rozbieżności pomiędzy kompleksowym AI Act Unii Europejskiej a fragmentarycznym podejściem Stanów Zjednoczonych stanowią poważne wyzwanie. Mogą one prowadzić do rosnących kosztów zgodności, istotnych komplikacji operacyjnych i potencjalnych ograniczeń w dostępie do rynków. Konsekwencje wykraczają daleko poza granice regionów.

AI Act, podobnie jak wcześniejsze ogólne rozporządzenie o ochronie danych (RODO), ma znaczący zasięg eksterytorialny – tzw. „Efekt Brukseli”. Oznacza to, że prawo to dotyczy wszystkich organizacji działających, bezpośrednio lub pośrednio, na terenie Unii Europejskiej. Tak szerokie zastosowanie przekształca regionalne przepisy w de facto globalny standard dla wielu międzynarodowych firm. W konsekwencji liderzy C-level, niezależnie od kraju siedziby spółki, muszą zdobyć pogłębione zrozumienie regulacji UE. Brak zgodności może bezpośrednio ograniczyć dostęp do rynków globalnych i skutkować poważnymi karami finansowymi, co czyni to krytycznym elementem strategicznego podejmowania decyzji.

Kompleksowy AI Act UE: Ramy regulacyjne oparte na analizie ryzyka

Unia Europejska umocniła swoją pozycję globalnego lidera w zakresie regulacji AI, przyjmując w czerwcu 2024 roku AI Act. To szeroko zakrojone ustawodawstwo ma na celu stworzenie ram prawnych dla godnej zaufania sztucznej inteligencji, wspierając innowacje przy jednoczesnym starannym ograniczaniu ryzyk dla praw człowieka, bezpieczeństwa i wartości demokratycznych.

Podejście warstwowe: systemy AI o niedopuszczalnym, wysokim, ograniczonym i minimalnym ryzyku

AI Act opiera się na szczegółowym podejściu warstwowym, klasyfikując systemy w zależności od poziomu ryzyka związanego z ich użyciem. Ta struktura determinuje różne wymogi i obowiązki dla dostawców oraz użytkowników systemów AI.

Systemy AI o niedopuszczalnym ryzyku

Zostają całkowicie zakazane ze względu na oczywiste zagrożenie dla bezpieczeństwa, źródeł utrzymania i praw podstawowych. Do zakazanych praktyk należą m.in.: szkodliwa manipulacja i dezinformacja, wykorzystywanie podatności osób, scoring społeczny, ocena ryzyka popełnienia przestępstwa, nieukierunkowane zbieranie danych z internetu czy monitoringu w celu tworzenia baz rozpoznawania twarzy, rozpoznawanie emocji w pracy i edukacji, kategoryzacja biometryczna celem wydedukowania cech chronionych, a także zdalna identyfikacja biometryczna w czasie rzeczywistym przez służby porządkowe w miejscach publicznych. Zakaz ten odzwierciedla etyczne i społeczne zobowiązania UE, które stawia prawa człowieka ponad swobodny rozwój technologii.Systemy AI wysokiego ryzyka

Obejmują wiele zastosowań mogących stwarzać „poważne ryzyka” dla zdrowia, bezpieczeństwa i praw podstawowych. Przykłady:komponenty bezpieczeństwa AI w infrastrukturach krytycznych (np. transport),

rozwiązania edukacyjne determinujące dostęp do nauki lub kariery zawodowej (np. oceny egzaminów),

komponenty bezpieczeństwa produktów (np. chirurgia wspomagana robotami),

narzędzia do zarządzania pracownikami i rekrutacji (np. sortowanie CV),

systemy decydujące o dostępie do kluczowych usług publicznych i prywatnych (np. scoring kredytowy),

systemy biometryczne (identyfikacja, rozpoznawanie emocji, kategoryzacja),

narzędzia wykorzystywane w organach ścigania (np. ocena wiarygodności dowodów),

zastosowania w migracji, azylu i kontroli granic (np. automatyczna analiza wniosków wizowych),

rozwiązania AI w wymiarze sprawiedliwości i procesach demokratycznych (np. przygotowywanie projektów wyroków).

Systemy AI o ograniczonym ryzyku

Podlegają obowiązkom transparentności, aby budować zaufanie. Przykładowo: użytkownik musi być poinformowany, że wchodzi w interakcję z AI (np. chatboty), a dostawcy generatywnej AI muszą oznaczać treści tworzone przez AI (np. deepfake’i, treści publicystyczne).Systemy AI o minimalnym ryzyku

Obejmują rozwiązania niosące niskie ryzyko, np. realizujące wąskie zadania proceduralne, usprawniające wyniki działań ludzkich lub wykrywające schematy w procesie decyzyjnym bez ich zastępowania. Dla takich systemów przewidziano niewielkie, a czasem żadne obowiązki prawne.Tabela 1: Kategorie ryzyka i kluczowe obowiązki w ramach AI Act UE

Kategoria ryzyka Definicja / Przykłady Kluczowe obowiązki (dostawcy i użytkownicy) Niedopuszczalne Jasne zagrożenie dla bezpieczeństwa, źródeł utrzymania, praw (np. scoring społeczny, biometryczna identyfikacja w czasie rzeczywistym w przestrzeni publicznej, szkodliwa manipulacja) Zakazane Wysokie Poważne ryzyka dla zdrowia, bezpieczeństwa, praw podstawowych (np. AI w infrastrukturze krytycznej, urządzeniach medycznych, narzędziach rekrutacyjnych i pracowniczych, scoring kredytowy, organy ścigania) Dostawcy: kompleksowe zarządzanie ryzykiem i jakością, zarządzanie danymi, dokumentacja techniczna, rejestrowanie/logowanie, nadzór ludzki, dokładność, odporność, cyberbezpieczeństwo, ocena zgodności, oznakowanie CE, rejestracja, działania naprawcze.

Użytkownicy (deployerzy): stosowanie zgodnie z instrukcjami, użycie odpowiednich danych wejściowych, monitorowanie i logowanie, informowanie pracowników/użytkowników, rejestracja, współpraca z organami nadzoruOgraniczone Konieczność zapewnienia przejrzystości (np. chatboty, deepfake’i, treści publiczne generowane przez AI) Specyficzne obowiązki ujawniania: informowanie użytkowników o interakcji z AI, wyraźne oznaczanie treści generowanych przez AI Minimalne Niższe ryzyko (np. filtry spamu, proste gry, wąskie zadania proceduralne, usprawnienia działań ludzkich) Niewiele lub brak szczególnych obowiązków poza ogólnymi standardami bezpieczeństwa Surowe obowiązki dotyczące systemów AI wysokiego ryzyka: wymagania w zakresie projektowania, rozwoju i wdrażania

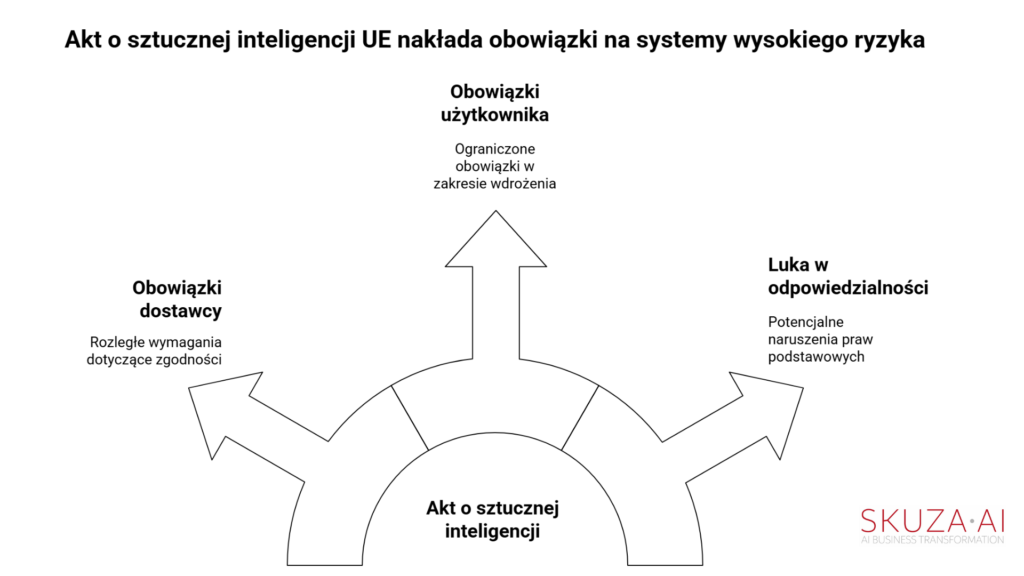

Akt o sztucznej inteligencji UE (EU AI Act) nakłada najbardziej rygorystyczne wymagania dotyczące zgodności na systemy AI wysokiego ryzyka. W przypadku dostawców takich systemów obowiązki są rozległe i muszą zostać spełnione, zanim systemy trafią na rynek. Obejmują one m.in. ustanowienie kompleksowego systemu zarządzania ryzykiem, systemu zarządzania jakością oraz solidnych procesów zarządzania i nadzoru nad danymi. Dostawcy są zobowiązani do prowadzenia dokumentacji technicznej wykazującej zgodność ze wszystkimi istotnymi wymaganiami, do skrupulatnego rejestrowania działań (w tym automatycznego logowania zdarzeń) oraz do udostępniania kluczowych informacji użytkownikom w celu zapewnienia prawidłowego korzystania z systemu AI. Ponadto dostawcy muszą zagwarantować odpowiedni nadzór człowieka, osiągnąć wysoki poziom dokładności, odporności i cyberbezpieczeństwa, przejść rygorystyczny proces oceny zgodności, uzyskać unijną deklarację zgodności oraz umieścić oznakowanie CE na swoich systemach. Wymagana jest także rejestracja w unijnej lub krajowej bazie danych, a w przypadku stwierdzenia niezgodności – wdrożenie działań naprawczych.

Choć główny ciężar obowiązków spoczywa na dostawcach, użytkownicy systemów AI wysokiego ryzyka (tzw. deployerzy) również mają istotne zadania. Muszą korzystać z systemu zgodnie z instrukcjami dostawcy, zapewniać, że dane wejściowe są istotne i wystarczająco reprezentatywne dla zamierzonego celu, monitorować działanie systemu oraz przechowywać automatycznie generowane logi. Pracodawcy, jako deployerzy, muszą informować pracowników i ich przedstawicieli o użyciu systemów AI wysokiego ryzyka. Warto zauważyć, że organizacje społeczeństwa obywatelskiego wskazują, iż Akt nakłada „minimalne obowiązki na użytkowników” poza tymi bezpośrednimi wymogami. Użytkownicy nie są wyraźnie zobowiązani do podejmowania dodatkowych działań, takich jak analiza potencjalnych skutków dla praw podstawowych, równości czy dostępności, ani do konsultacji z grupami, których może to dotyczyć, czy też do aktywnego minimalizowania potencjalnych szkód poza stosowaniem się do instrukcji dostawcy. Tworzy to potencjalną lukę w zakresie odpowiedzialności w ramach AI Act. O ile dostawca może zapewnić, że system AI jest technicznie zgodny z wymogami, o tyle konkretny kontekst jego wdrożenia przez użytkownika może prowadzić do naruszeń praw podstawowych. Przykładowo, system uwierzytelniania twarzy może spełniać wszystkie wymagania techniczne Aktu, lecz jego użycie w określonym centrum handlowym mogłoby naruszać przepisy o ochronie danych i zakaz dyskryminacji, prowadząc do nieproporcjonalnej inwigilacji. Sugeruje to, że odpowiedzialność za niewłaściwe użycie w kontekście wdrożenia może ostatecznie spadać na istniejące przepisy dotyczące ochrony danych lub praw człowieka, a nie być w pełni uregulowana w ramach samego AI Act.

Przejrzystość i odpowiedzialność: Wymogi dla sztucznej inteligencji ogólnego przeznaczenia (GPAI) i specyficznych przypadków użycia

Przejrzystość jest fundamentem unijnej ustawy o AI (EU AI Act), która wymaga jasnych ujawnień w przypadku różnych zastosowań sztucznej inteligencji. Dostawcy modeli sztucznej inteligencji ogólnego przeznaczenia (GPAI), takich jak generatywna AI, muszą ujawniać źródła danych treningowych oraz stosowane metody, aby zapewnić możliwość śledzenia i wyjaśnienia wyników ich działania. To proaktywne podejście do przejrzystości w odniesieniu do modeli GPAI, w szczególności wymóg ujawniania danych treningowych i metodologii, stanowi strategiczną próbę rozwiązania problemu tzw. „czarnej skrzynki” w złożonych systemach AI. Ten krok ma na celu budowanie zaufania społecznego oraz umożliwienie skuteczniejszego nadzoru. Biorąc pod uwagę wpływ rynku UE, podejście to może w praktyce ustanowić globalny precedens dla modeli bazowych AI, zmuszając twórców na całym świecie do przyjęcia podobnych praktyk przejrzystości, aby uzyskać dostęp do rynku europejskiego.

Treści generowane przez AI, takie jak deepfake’i oraz teksty publikowane w interesie publicznym, muszą być wyraźnie i jednoznacznie oznaczone jako stworzone przez AI. W przypadku systemów wysokiego ryzyka obowiązki dotyczące przejrzystości obejmują także jednoznaczną identyfikację dostawcy, wskazanie zamierzonego celu systemu, jego dokładności, odporności, zabezpieczeń cybernetycznych oraz powiązanych ryzyk. Tak kompleksowe podejście do przejrzystości ma na celu ograniczenie ryzyka i ochronę praw podstawowych.

Ustawa stara się zrównoważyć wymogi przejrzystości z ochroną tajemnic handlowych i informacji o charakterze własnościowym. Firmy mogą udostępniać organom nadzoru wyłącznie niezbędne informacje, objęte ścisłymi klauzulami poufności, oraz przedstawiać ogólne wyjaśnienia dotyczące logiki działania systemu bez ujawniania wszystkich szczegółowych aspektów technicznych. Ochrona umowna, taka jak umowy o zachowaniu poufności (NDA), może być również stosowana w relacjach z użytkownikami i stronami trzecimi w celu ograniczenia ujawniania szczegółowych informacji.

Egzekwowanie i kary: wysokie grzywny oraz „Efekt Brukseli” związany z eksterytorialnym zasięgiem

Nieprzestrzeganie unijnej ustawy o AI (EU AI Act) wiąże się ze znacznymi karami finansowymi, mającymi na celu odstraszanie od naruszeń i zapewnienie zgodności z przepisami. Maksymalne grzywny mogą sięgać 40 mln euro lub 7% rocznego globalnego obrotu firmy za stosowanie zakazanych systemów AI, 20 mln euro lub 4% za naruszenia związane z danymi lub przejrzystością oraz 15 mln euro lub 3% za inne obowiązki. Podanie nieprawidłowych informacji organom nadzoru może również skutkować znacznymi karami – nawet do 7,5 mln euro lub 1% rocznego obrotu. Kary te należą do najwyższych na świecie w zakresie regulacji AI, podkreślając determinację UE w egzekwowaniu przepisów.

Kluczową cechą ustawy o AI, a zarazem istotnym strategicznym wyzwaniem dla globalnych przedsiębiorstw, jest jej eksterytorialny zasięg, często określany mianem „Efektu Brukseli”. Podobnie jak w przypadku RODO (GDPR), ustawa ma zastosowanie do wszystkich organizacji działających, bezpośrednio lub pośrednio, na terytorium Unii Europejskiej, niezależnie od lokalizacji ich siedziby. Oznacza to, że każda firma – czy to z USA, Azji, czy innego regionu – która oferuje systemy AI lub usługi klientom w UE, bądź której systemy AI przetwarzają dane dotyczące obywateli UE, musi przestrzegać przepisów ustawy.

W praktyce zmusza to globalne przedsiębiorstwa do dostosowania rozwoju i wdrażania AI do standardów unijnych, aby uzyskać dostęp do lukratywnego rynku europejskiego. Połączenie wysokich kar finansowych oraz eksterytorialnego zasięgu ustawy sprawia, że zgodność z przepisami AI staje się nie tylko formalnością prawną, lecz także kluczowym strategicznym imperatywem dla globalnych firm. Brak zgodności niesie ze sobą nie tylko poważne ryzyko finansowe, ale również bezpośrednio wpływa na dostęp do rynku oraz pozycję konkurencyjną, czyniąc proaktywne przestrzeganie przepisów niezbędnym dla długoterminowej stabilności biznesowej.

Ewoluujący krajobraz AI w Stanach Zjednoczonych: rozproszony ekosystem

W wyraźnym kontraście do spójnego i kompleksowego podejścia Unii Europejskiej, amerykański krajobraz regulacyjny dotyczący AI najlepiej opisać jako dynamiczny i rozproszony ekosystem. Ten zdecentralizowany model w dużej mierze opiera się na obowiązujących przepisach prawa, wytycznych wydawanych przez organy wykonawcze oraz coraz bardziej rozbudowanej mozaice regulacji na poziomie poszczególnych stanów.

Zdecentralizowane i sektorowe podejście: opieranie się na istniejących przepisach i dobrowolnych ramach

Amerykańskie podejście do regulacji AI ma charakter „patchworkowy”, wysoce zdecentralizowany, obejmujący różne agencje federalne oraz poszczególne stany. W przeciwieństwie do jednolitej i kompleksowej ustawy o AI przyjętej w UE, Stany Zjednoczone opierają się głównie na adaptacji istniejących przepisów oraz wydawaniu dobrowolnych wytycznych, zamiast uchwalać dedykowane regulacje prawne dotyczące AI na poziomie federalnym.

Strategia ta ma na celu znalezienie równowagi między bezpieczeństwem publicznym i ochroną praw obywatelskich, a szeroko przyjmowanym założeniem, że amerykańskie firmy technologiczne muszą mieć swobodę innowacji, aby kraj mógł utrzymać globalną przewagę konkurencyjną.

Choć takie rozproszone podejście może być postrzegane jako „proinnowacyjne”, ponieważ unika stworzenia jednego, potencjalnie obciążającego, federalnego systemu regulacyjnego, jednocześnie generuje ono znaczną złożoność, niepewność oraz wyższe koszty zgodności dla przedsiębiorstw działających w całym kraju. Wymaga to wysoce elastycznej i wielowarstwowej strategii compliance, ponieważ firmy muszą poruszać się po różnorodnych, a czasem sprzecznych wymaganiach obowiązujących w różnych jurysdykcjach.

Inicjatywy federalne: rola rozporządzeń prezydenckich oraz Ram Zarządzania Ryzykiem AI NIST (AI RMF)

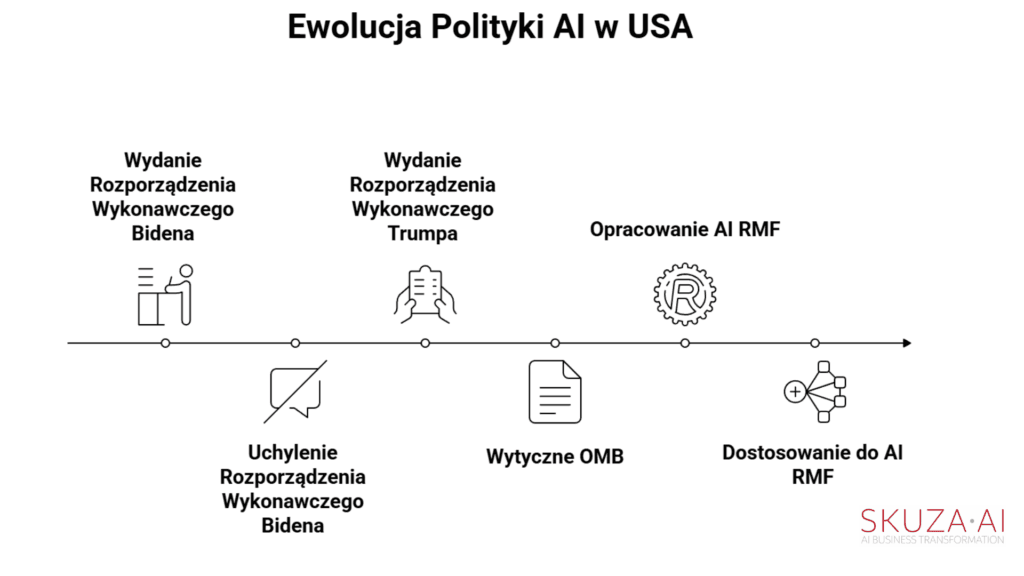

Stanowisko rządu federalnego w zakresie zarządzania sztuczną inteligencją cechuje się zmiennością, szczególnie w związku ze zmianami administracji. Rozporządzenie wykonawcze prezydenta Bidena nr 14110, wydane w październiku 2023 roku, koncentrowało się na bezpiecznym, rzetelnym i godnym zaufania rozwoju oraz wykorzystaniu AI, mając na celu ograniczenie społecznych szkód, takich jak oszustwa, dyskryminacja, stronniczość czy dezinformacja. Jednak rozporządzenie to zostało uchylone 20 stycznia 2025 roku.

Następnie, prezydent Trump wydał rozporządzenie wykonawcze nr 14179 w styczniu 2025 roku, które wyraźnie podkreślało „usuwanie barier dla amerykańskiego przywództwa w dziedzinie sztucznej inteligencji”, promując „proinnowacyjny” i „pro-biznesowy ekosystem AI”. Uzupełniając to, Biuro Zarządzania i Budżetu Białego Domu (OMB) wydało w kwietniu 2025 roku nowe wytyczne dotyczące wykorzystania i zamówień publicznych AI w administracji federalnej, sygnalizując zmianę polityki w kierunku „proinnowacyjnego, prokonkurencyjnego i nastawionego na przyszłość podejścia”. Tak szybka zmiana oraz filozoficzna rozbieżność w zakresie wytycznych wykonawczych powodują znaczną niestabilność i niepewność regulacyjną dla przedsiębiorstw. Zmusza to firmy do ciągłej reewaluacji swojej strategii w odniesieniu do priorytetów federalnych, nawet gdy wytyczne te są w dużej mierze dobrowolne lub ograniczone do zamówień publicznych, co dodaje element nieprzewidywalności do długoterminowych strategii AI.

Równolegle, Narodowy Instytut Standaryzacji i Technologii (NIST) opracował Ramowy Model Zarządzania Ryzykiem AI (AI RMF). Jest to dobrowolne narzędzie, którego celem jest poprawa zarządzania ryzykiem związanym z AI. Ramy mają na celu budowanie zaufania, obejmując cechy takie jak: dokładność, wyjaśnialność, niezawodność, prywatność, odporność, bezpieczeństwo, ochrona oraz ograniczanie niezamierzonej stronniczości. AI RMF zostało zaprojektowane jako rozwiązanie oparte na konsensusie, elastyczne i napisane prostym językiem, co czyni je dostępnym dla szerokiego grona odbiorców, w tym dla kadry kierowniczej.

Jego główne elementy – Zarządzaj (Govern), Mapuj (Map), Mierz (Measure) i Kontroluj (Control) – stanowią systematyczne podejście do zarządzania ryzykiem. Co istotne, znaczne dostosowanie się do AI RMF NIST może służyć jako linia obrony przed działaniami egzekucyjnymi w ramach niektórych przepisów stanowych, takich jak Ustawa o Odpowiedzialnym Zarządzaniu Sztuczną Inteligencją w Teksasie (TRAIGA). Podkreśla to rosnące znaczenie dobrowolnych ram regulacyjnych w sytuacji braku kompleksowej legislacji federalnej.

Mozaika przepisów stanowowych: kluczowe regulacje na poziomie stanowym

Wobec braku kompleksowych federalnych regulacji dotyczących AI, poszczególne stany stają się coraz bardziej aktywne w tworzeniu własnych przepisów, co prowadzi do powstania złożonej i często sprzecznej „mozaiki” różnorodnych ustaw. Trend ten jest znaczący – w ciągu jednego roku wprowadzono ponad 250 projektów ustaw dotyczących AI w ochronie zdrowia w 34 stanach, a w 2024 r. aż 45 stanów przedstawiło własne projekty ustaw dotyczących AI. Niewprowadzenie proponowanego federalnego moratorium na regulacje stanowe oznacza, że ta „mozaika” będzie się dalej rozwijać i różnicować. Zmusza to przedsiębiorstwa do zarządzania niezwykle szczegółowymi, specyficznymi dla poszczególnych jurysdykcji wymogami zgodności, co znacząco zwiększa złożoność operacyjną, koszty prawne i ryzyko niezgodności w ramach ich zróżnicowanej działalności.

Kluczowe regulacje na poziomie stanowym obejmują:

Kolorado – ustawa SB 205 (wejście w życie: luty 2026):

To przełomowe ustawodawstwo ma stworzyć jeden z najbardziej szczegółowych systemów regulacyjnych dotyczących AI w USA. Nakłada istotne obowiązki na firmy korzystające z systemów AI „wysokiego ryzyka”, w tym w obszarze zatrudnienia. Kluczowe wymogi obejmują przeprowadzanie ocen wpływu, informowanie osób o użyciu AI oraz podejmowanie działań w celu ograniczenia dyskryminacji.Teksas – Texas Responsible Artificial Intelligence Governance Act (TRAIGA, wejście w życie: styczeń 2026):

TRAIGA przyjmuje unikalne, „przyjazne biznesowi” podejście, różniące się od UE i Kolorado tym, że nie klasyfikuje systemów AI według poziomu ryzyka i nakłada jedynie ograniczone wymogi dotyczące przejrzystości. Najbardziej restrykcyjne przepisy dotyczą głównie instytucji rządowych stanu oraz dostawców usług medycznych, a większość prywatnych firm obciążają jedynie minimalnie, poza zakazami dotyczącymi m.in. dyskryminacji czy tworzenia materiałów związanych z wykorzystywaniem seksualnym dzieci (CSAM). TRAIGA przewiduje 60-dniowy okres na naprawienie naruszeń oraz wyłącznie kary cywilne, bez sankcji karnych.Nowy Jork (NYC) – Local Law 144 (wejście w życie: lipiec 2023):

To pionierskie lokalne prawo reguluje zautomatyzowane narzędzia podejmowania decyzji dotyczących zatrudnienia (AEDTs) stosowane przy rekrutacji lub awansach, wymagając corocznych, niezależnych audytów stronniczości oraz informowania kandydatów i pracowników.Illinois – Artificial Intelligence Video Interview Act (wejście w życie: styczeń 2020):

Ustawa ta zobowiązuje pracodawców korzystających z AI do analizy nagranych rozmów kwalifikacyjnych do informowania kandydatów, uzyskiwania ich zgody oraz ujawniania, jak działa dana technologia.Kalifornia:

Regulatorzy aktywnie przyjmują nowe procedury egzekwowania przepisów antydyskryminacyjnych w odniesieniu do zautomatyzowanych systemów decyzyjnych (ADS), które mogą wejść w życie już w październiku 2025 r. Kalifornia była również liderem w wysiłkach na rzecz regulacji dezinformacji politycznej generowanej przez AI.Egzekwowanie przepisów przez poszczególne agencje: jak federalne agencje stosują istniejące regulacje wobec AI

Wobec braku kompleksowego prawa federalnego dotyczącego AI, różne agencje federalne aktywnie stosują istniejące, szerokie ramy prawne wobec sztucznej inteligencji, tworząc niezwykle złożone i często nieprzewidywalne środowisko egzekwowania prawa. Firmy narażone są na potencjalną odpowiedzialność na podstawie wielu, często nakładających się przepisów, co wymaga zaawansowanej interpretacji prawnej oraz proaktywnego zarządzania ryzykiem w różnych obszarach działalności.

Federal Trade Commission (FTC)

FTC korzysta ze swoich uprawnień wynikających z Sekcji 5 ustawy o FTC do zwalczania „nieuczciwych lub wprowadzających w błąd działań lub praktyk” w kontekście AI. Obejmuje to analizę przesadzonych twierdzeń dotyczących wydajności produktów opartych na AI, fałszywe oznaczanie produktów jako napędzanych AI, nieprzejrzyste praktyki w zakresie danych (zwłaszcza dotyczących danych biometrycznych lub osobowych) oraz stronniczość lub dyskryminację w systemach decyzyjnych AI. FTC podjęła działania egzekucyjne przeciwko firmom za wprowadzające w błąd twierdzenia dotyczące AI (np. Workado, Cleo AI), a także za brak zapobiegania szkodom dla konsumentów wynikającym z nadużyć AI – jak w przypadku technologii rozpoznawania twarzy firmy Rite Aid.

Department of Justice (DOJ)

DOJ zapowiedział twarde podejście wobec przestępstw związanych z nadużywaniem AI, podkreślając, że obowiązujące przepisy mają zastosowanie. Zastępca Prokuratora Generalnego Monaco jasno stwierdziła: „Dyskryminacja przy użyciu AI to wciąż dyskryminacja; zmowa cenowa przy użyciu AI to wciąż zmowa cenowa; kradzież tożsamości przy użyciu AI to wciąż kradzież tożsamości”. DOJ zamierza dążyć do zaostrzonych wyroków w przypadku przestępstw „znacząco bardziej niebezpiecznych” z powodu wykorzystania AI. Wydział Praw Obywatelskich skupia się na zagadnieniach związanych z przecięciem AI i praw obywatelskich, wydając wytyczne dotyczące dyskryminacji osób z niepełnosprawnościami w procesach rekrutacyjnych i przeciwdziałania stronniczości algorytmicznej w sektorze mieszkaniowym. DOJ wykorzystuje również ustawę o fałszywych roszczeniach (False Claims Act), aby ścigać naruszenia praw obywatelskich przez beneficjentów funduszy federalnych, w tym te związane z „rasistowskimi preferencjami, politykami, programami i działaniami, w tym w ramach programów DEI”.

Department of Health and Human Services (HHS) / Office for Civil Rights (OCR)

HHS, poprzez OCR, wydał wytyczne dotyczące stosowania AI w ochronie zdrowia, kładąc nacisk na zakaz dyskryminacji wynikający z Sekcji 1557 ustawy o opiece zdrowotnej (Affordable Care Act) oraz zgodność z HIPAA. OCR wymaga od podmiotów regulowanych podejmowania rozsądnych działań w celu identyfikacji i ograniczenia ryzyka bezprawnej dyskryminacji ze strony narzędzi AI, które opierają się na chronionych cechach jako zmiennych wejściowych. HIPAA ma pełne zastosowanie do systemów AI przetwarzających chronione informacje zdrowotne (PHI), nakazując przestrzeganie Zasad Bezpieczeństwa, Standardu Minimalnej Konieczności w dostępie do danych, wymogów dotyczących de-identyfikacji danych, przeprowadzania ocen ryzyka związanych z AI oraz zarządzania cyklem życia systemów, wdrażania poprawek bezpieczeństwa w przypadku luk w AI, a także zawierania solidnych umów z dostawcami AI (BAA). Zalecany jest także silny nadzór człowieka nad decyzjami AI.

Consumer Financial Protection Bureau (CFPB)

CFPB stosuje ustawę o równym dostępie do kredytu (ECOA) oraz ustawę o sprawiedliwym raportowaniu kredytowym (FCRA) wobec modeli AI używanych w kredytach i scoringu kredytowym. Wymaga wydawania konsumentom „zawiadomień o negatywnej decyzji” (adverse action notices) zawierających konkretne powody odmowy kredytu lub innych negatywnych decyzji, nawet jeśli oparte są one na złożonych algorytmach AI. CFPB podkreśla, że nietradycyjne czynniki stosowane przez modele AI niosą podwyższone ryzyko, jeśli nie są zgodne z oczekiwaniami konsumentów dotyczącymi tradycyjnych kryteriów kredytowych.

Equal Employment Opportunity Commission (EEOC)

Choć wytyczne z czasów administracji Bidena dotyczące AI w miejscu pracy zostały usunięte ze stron agencji po zmianie administracji, nadal w pełni obowiązują federalne przepisy antydyskryminacyjne, takie jak Tytuł VII ustawy o prawach obywatelskich oraz ustawa o Amerykanach z Niepełnosprawnościami (ADA). Pracodawcy pozostają odpowiedzialni za dyskryminację ze względu na skutek (disparate impact) oraz dyskryminację osób z niepełnosprawnościami, nawet jeśli stronniczość jest niezamierzona lub narzędzie AI zostało opracowane i wdrożone przez zewnętrznego dostawcę.

Gramm-Leach-Bliley Act (GLBA)

To federalne prawo zobowiązuje instytucje finansowe do ochrony wrażliwych danych klientów poprzez kompleksowy program bezpieczeństwa informacji, znany jako Safeguards Rule. Kluczowe wymogi obejmują: wyznaczenie wykwalifikowanej osoby odpowiedzialnej za program, identyfikację i ocenę ryzyk, wdrożenie solidnych zabezpieczeń, ciągłe monitorowanie i testowanie, szkolenie personelu, rygorystyczny nadzór nad dostawcami (w tym umowy BAA), a także kompleksowy plan reagowania na incydenty. Rozwiązania z zakresu zarządzania tożsamością wspierane przez AI są coraz częściej wykorzystywane do poprawy zgodności z GLBA, m.in. przez identyfikację nietypowych wzorców dostępu i usprawnianie procesów przeglądu uprawnień.

Tabela 2: Kluczowe agencje federalne USA i ich obszary regulacji dotyczących AI

Agencja federalna Główny obszar regulacji (w kontekście AI) Powiązane ustawy/wytyczne Przykłady egzekwowania prawa / wytycznych FTC (Federal Trade Commission) Ochrona konsumentów, zwalczanie fałszywych twierdzeń, uprzedzenia, prywatność Ustawa o FTC – Sekcja 5 Nadużycia przy wykorzystaniu rozpoznawania twarzy przez Rite Aid, wprowadzające w błąd twierdzenia o AI (Workado, Cleo AI) DOJ (Department of Justice) Prawa obywatelskie, przestępcze nadużycia, stronniczość w organach ścigania Ustawa o prawach obywatelskich, ADA, ustawa o fałszywych roszczeniach (False Claims Act) Stronniczość algorytmiczna w sektorze mieszkaniowym, zaostrzone kary za nadużycia AI, inicjatywa przeciwko oszustwom związanym z prawami obywatelskimi HHS/OCR (Department of Health and Human Services / Office for Civil Rights) AI w ochronie zdrowia, zgodność z HIPAA, zakaz dyskryminacji HIPAA, ACA – Sekcja 1557 Niedyskryminacja w opiece nad pacjentami, zgodność systemów AI z HIPAA CFPB (Consumer Financial Protection Bureau) Usługi finansowe, scoring kredytowy, sprawiedliwy dostęp do kredytu FCRA, ECOA Zawiadomienia o negatywnej decyzji kredytowej (adverse action notices) dla decyzji AI, analiza czynników nietradycyjnych EEOC (Equal Employment Opportunity Commission) Dyskryminacja w zatrudnieniu, stronniczość w rekrutacji Title VII, ADA Dyskryminacja pośrednia (disparate impact) w procesach rekrutacyjnych opartych na AI, odpowiedzialność za narzędzia dostawców zewnętrznych

Kluczowe rozbieżności i zbieżności: filozofie regulacyjne UE vs. USA

Odmienne podejścia do regulacji sztucznej inteligencji w Unii Europejskiej i Stanach Zjednoczonych odzwierciedlają głęboko zakorzenione różnice w tradycjach prawnych, wartościach społecznych oraz priorytetach gospodarczych. Zrozumienie tych fundamentalnych rozbieżności, a także rodzących się obszarów zbieżności, jest kluczowe dla opracowania spójnej globalnej strategii dotyczącej AI.

Proaktywne vs. reaktywne: fundamentalne różnice w filozofii regulacyjnej

Unijny Akt o sztucznej inteligencji (EU AI Act) stanowi „proaktywne” i kompleksowe ramy prawne zaprojektowane specjalnie do regulacji AI, których celem jest kształtowanie rynku i ograniczanie ryzyka, zanim się ono zmaterializuje. Fundamentem tego podejścia są „demokratyczny nadzór i wartości oparte na prawach człowieka”, z naciskiem na prewencyjne względy etyczne i bezpieczeństwa. Takie podejście ma na celu ustanowienie jasnych granic i obowiązków z góry, tworząc uporządkowane środowisko dla rozwoju i wdrażania AI w UE.

Dla kontrastu, USA przyjmują podejście bardziej „reaktywne” i zdecentralizowane, polegające głównie na adaptacji istniejących przepisów oraz wydawaniu dobrowolnych wytycznych. Strategia amerykańska stawia na wspieranie innowacyjności i pozwalanie mechanizmom rynkowym kierować rozwojem technologicznym, przy czym działania egzekucyjne podejmowane są zazwyczaj dopiero po zidentyfikowaniu szkód lub praktyk wprowadzających w błąd. Ta fundamentalna różnica filozoficzna odzwierciedla odmienne priorytety społeczne: UE priorytetowo traktuje prawa podstawowe, bezpieczeństwo i aspekty etyczne poprzez prewencyjne, wiążące regulacje, podczas gdy USA stawiają na konkurencyjność gospodarczą i szybkie innowacje, podejmując działania głównie w formie późniejszej egzekucji prawa i dobrowolnych standardów branżowych. Ta rozbieżność bezpośrednio wpływa na tempo wdrażania AI, charakter obciążeń związanych z przestrzeganiem przepisów oraz ogólną „apetytowość” ryzyka w zakresie innowacji AI w obu regionach.

Klasyfikacja ryzyka i zakres: zharmonizowane kategorie UE kontra brak jednolitych ram w USA

Istotną praktyczną różnicą jest kwestia klasyfikacji ryzyka. Akt o sztucznej inteligencji UE (EU AI Act) wprowadza jasny, zharmonizowany i warstwowy system klasyfikacji ryzyka (niedopuszczalne, wysokie, ograniczone, minimalne), który zapewnia przewidywalne i ustandaryzowane ramy dla przedsiębiorstw działających w 27 państwach członkowskich. Dzięki temu firmy mogą z góry rozumieć swoje obowiązki w zależności od wrodzonego poziomu ryzyka związanego z ich systemami AI.

W USA natomiast na poziomie federalnym brakuje jednolitych, kompleksowych ram opartych na klasyfikacji ryzyka dla AI. Niektóre stany, takie jak Kolorado, przyjmują podejście oparte na kategoriach wysokiego ryzyka i nakładają rygorystyczne obowiązki, podczas gdy inne, np. Teksas, wyraźnie decydują się na brak klasyfikacji systemów AI według poziomów ryzyka. Brak spójnego, federalnie narzuconego systemu klasyfikacji ryzyka AI w USA oznacza, że międzynarodowe przedsiębiorstwa muszą samodzielnie prowadzić złożone, wielojurysdykcyjne oceny ryzyka, aby poruszać się wśród rozbieżnych definicji na poziomie poszczególnych stanów. Taka niespójność może prowadzić do wyższych wewnętrznych kosztów zapewnienia zgodności, większej niepewności prawnej i mniej uspójnionego podejścia w porównaniu z bardziej ustandaryzowanymi i przewidywalnymi ramami UE.

Ciężar zgodności i wpływ operacyjny: scentralizowana zgodność w UE kontra poruszanie się po rozdrobnionym krajobrazie USA

Wpływ operacyjny odmiennych filozofii regulacyjnych jest znaczący. Akt o sztucznej inteligencji UE (EU AI Act), pomimo rygorystycznych wymagań, oferuje jednolite, zharmonizowane ramy prawne obowiązujące spójnie we wszystkich 27 państwach członkowskich. Oznacza to, że gdy firma zrozumie i wdroży środki zgodności wymagane przez EU AI Act, może stosować te same standardy w całej Unii, co potencjalnie upraszcza długoterminowe zarządzanie zgodnością. Początkowa inwestycja w spełnienie wymogów może być znaczna, lecz jednolitość w regionie sprzyja skalowalności.

W USA natomiast „mozaika” wytycznych agencji federalnych, zróżnicowanych przepisów stanowowych i lokalnych tworzy niezwykle złożony i potencjalnie sprzeczny ciężar regulacyjny dla firm działających na terenie całego kraju. Taka fragmentacja wymaga „ostrożnego, specyficznego dla jurysdykcji planowania”, a kierownictwo przewiduje, że dostosowanie się do tego dynamicznego krajobrazu znacząco podniesie koszty technologiczne, wymuszając korzystanie z zewnętrznych doradców prawnych i ciągłe aktualizowanie praktyk.

Podczas gdy ramy UE są bardziej nakazowe, ich jednolitość w całej wspólnocie może ostatecznie prowadzić do bardziej przewidywalnej i skalowalnej strategii zgodności dla przedsiębiorstw. W przeciwieństwie do tego, dynamiczny i rozdrobniony krajobraz USA wymaga stałego monitorowania, dostosowywania się oraz często odrębnych procedur operacyjnych dla każdej jurysdykcji, co prowadzi do wyższej bieżącej złożoności operacyjnej i kosztów prawnych.

Zarządzanie danymi, prywatność i transparentność: różnice w wymaganiach i podejściach

Zarządzanie danymi, prywatność i transparentność stanowią kluczowe elementy obu środowisk regulacyjnych, jednak sposób ich integracji i nacisk na poszczególne aspekty różnią się znacząco.

W UE Akt o sztucznej inteligencji (AI Act) wprost integruje solidne procesy zarządzania i nadzoru nad danymi jako podstawowy wymóg dla systemów AI wysokiego ryzyka. Transparentność odgrywa rolę centralną – nakłada obowiązek ujawniania źródeł danych treningowych, stosowanych metodologii oraz wyraźnego oznaczania treści generowanych przez AI. „Prywatność w fazie projektowania” (privacy by design) jest zasadą fundamentalną, osadzoną w całym procesie rozwoju technologii. Holistyczna integracja zarządzania danymi i transparentności w unijnych ramach regulacyjnych dotyczących AI tworzy spójniejsze i bardziej zintegrowane wyzwanie w zakresie zgodności.

W USA prywatność danych regulowana jest głównie poprzez mozaikę ustaw sektorowych, takich jak HIPAA dla ochrony zdrowia czy GLBA dla instytucji finansowych. Wymogi dotyczące transparentności są zazwyczaj węższe i często ograniczone do wybranych sektorów lub podmiotów rządowych (np. dostawców usług medycznych w Teksasie). Choć ramy NIST AI RMF promują transparentność i prywatność jako dobre praktyki, ich stosowanie na poziomie federalnym pozostaje dobrowolne. Firmy amerykańskie muszą poruszać się po rozproszonych przepisach dotyczących prywatności i bezpieczeństwa danych, które nie były pierwotnie tworzone z myślą o AI. Może to prowadzić do luk w zgodności, nakładania się wymogów lub nieefektywności przy ich stosowaniu w odniesieniu do nowych systemów AI.

Przeciwdziałanie uprzedzeniom i dyskryminacji: bezpośrednie zakazy w UE kontra oparcie się na istniejących przepisach w USA

Podejście do stronniczości algorytmicznej i dyskryminacji ujawnia kolejną istotną różnicę. Akt o sztucznej inteligencji UE (EU AI Act) przyjmuje podejście bezpośrednie, jednoznacznie zakazując systemów AI, które stanowią „niedopuszczalne ryzyko” ze względu na ich potencjał dyskryminacyjny (np. systemy oceny społecznej, kategoryzacja biometryczna oparta na cechach chronionych prawnie). Ponadto systemy wysokiego ryzyka muszą wykorzystywać wysokiej jakości zbiory danych, aby minimalizować ryzyko wyników dyskryminacyjnych. Takie podejście legislacyjne daje bardziej przejrzyste, specyficzne dla AI wytyczne.

W USA główną podstawą prawną pozostają istniejące przepisy dotyczące praw obywatelskich i zakazu dyskryminacji, takie jak Tytuł VII ustawy o prawach obywatelskich, ustawa o Amerykanach z Niepełnosprawnościami (ADA), ustawa o równym dostępie do kredytu (ECOA) czy ustawa o uczciwym dostępie do mieszkań (Fair Housing Act). Są one egzekwowane przez agencje takie jak EEOC, Wydział Praw Obywatelskich DOJ czy CFPB. Choć przepisy te stosuje się do AI, nie zostały one pierwotnie zaprojektowane z myślą o stronniczości algorytmicznej, co wymusza ich interpretację i adaptację do nowych kontekstów technologicznych. Niektóre stany, jak Kolorado, zaczynają wprowadzać obowiązek audytów uprzedzeń dla systemów AI wysokiego ryzyka.

To oparcie się na interpretacji istniejących, ogólnych przepisów antydyskryminacyjnych tworzy bardziej niejednoznaczne i potencjalnie reaktywne środowisko w zakresie przeciwdziałania dyskryminacji algorytmicznej, przerzucając większy ciężar na przedsiębiorstwa, które muszą samodzielnie identyfikować i minimalizować stronniczość – bez jednoznacznych, dostosowanych do AI wytycznych na szczeblu federalnym.

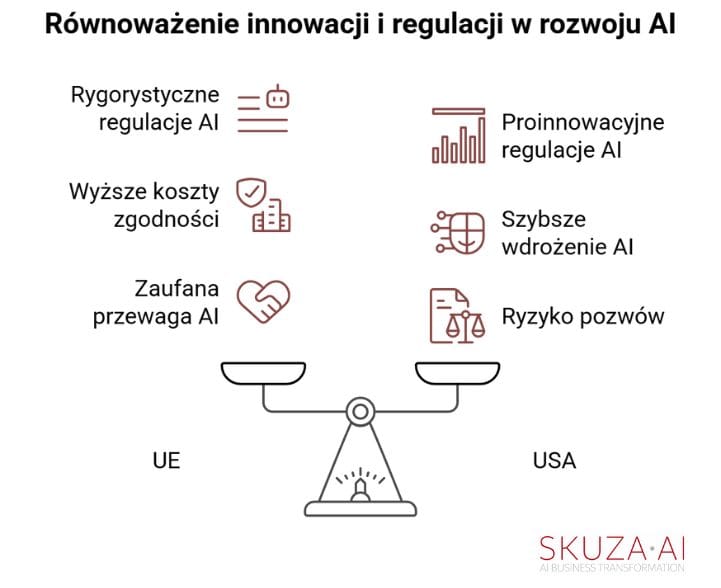

Innowacja vs. regulacja: równowaga między konkurencyjnością gospodarczą a zabezpieczeniami etycznymi

Odmienny nacisk na innowacje i regulacje w znaczący sposób kształtuje krajobraz konkurencyjny w zakresie rozwoju i wdrażania AI. UE, choć uznaje znaczenie wspierania innowacji, w Akcie o AI (AI Act) wyraźnie priorytetowo traktuje ograniczanie ryzyka dla praw człowieka, bezpieczeństwa i wartości demokratycznych poprzez rygorystyczne i kompleksowe regulacje. Odzwierciedla to przekonanie, że zaufana sztuczna inteligencja ostatecznie sprzyja zrównoważonej innowacyjności, nawet jeśli oznacza to wolniejsze tempo początkowego wdrożenia.

USA natomiast kładą silny nacisk na wspieranie innowacji AI i konkurencyjności gospodarczej, czego wyrazem są ostatnie federalne rozporządzenia wykonawcze promujące „proinnowacyjny” i „przyjazny biznesowi ekosystem AI” oraz koncentrujące się na „usuwaniu barier dla amerykańskiej innowacji AI”. Niewdrożenie szeroko zakrojonych ustaw stanowych dotyczących AI wynika częściowo z „obaw o innowacyjność”, co dodatkowo podkreśla tę priorytetyzację.

Firmy z siedzibą w UE mogą ponosić wyższe początkowe koszty zgodności i wolniej wchodzić na rynek, ale w zamian mogą zyskać przewagę konkurencyjną dzięki statusowi „zaufanej AI” oraz większemu zaufaniu konsumentów. Z kolei firmy amerykańskie mogą szybciej rozwijać i wdrażać AI, ale mogą też być bardziej narażone na ryzyko pozwów, nieprzewidywalne działania egzekucyjne oraz potencjalne szkody reputacyjne z powodu mniej precyzyjnych, reaktywnych regulacji.

Strategiczne imperatywy dla kadry zarządzającej (C-level): poruszanie się w globalnym labiryncie regulacji dotyczących AI

Biorąc pod uwagę złożony i rozbieżny globalny krajobraz regulacyjny dotyczący sztucznej inteligencji, kadra zarządzająca najwyższego szczebla musi przyjąć proaktywne i zaawansowane strategie, aby skutecznie zarządzać ryzykiem, zapewnić zgodność z przepisami oraz utrzymać przewagę konkurencyjną.

Przeprowadzenie kompleksowej oceny ryzyka AI: identyfikacja i klasyfikacja przypadków użycia AI w całej organizacji

Dogłębna wewnętrzna ocena ryzyka AI ma kluczowe znaczenie. Jest to szczególnie istotne w świetle podejścia UE opartego na analizie ryzyka oraz pojawiających się klasyfikacji wysokiego ryzyka w niektórych stanach USA, takich jak Kolorado. Organizacje powinny rozważyć wykorzystanie zasad określonych w NIST AI RMF, w szczególności jego komponentów Govern, Map, Measure, Control, aby systematycznie identyfikować i oceniać ryzyka związane z AI.

Choć ramy NIST mają charakter dobrowolny, ich zgodność z najlepszymi praktykami oraz potencjał do wykorzystania jako linia obrony w niektórych kontekstach prawnych w USA (np. w ramach ustawy TRAIGA w Teksasie) sprawiają, że są one wartościowym narzędziem. Stworzenie jednolitego, globalnego frameworku oceny ryzyka AI, opartego potencjalnie na zasadach takich jak NIST AI RMF, może zapewnić solidną bazę do spełniania wymogów zarówno w UE, jak i w USA.

Takie podejście pomaga identyfikować wspólne obszary ryzyka, takie jak uprzedzenia, prywatność czy bezpieczeństwo, które są regulowane w obu jurysdykcjach, choć różnymi mechanizmami. Umożliwia to bardziej efektywną strategię „compliance by design”, w której podstawowe środki kontroli ryzyka są wbudowane już od początku procesu.

Opracowanie solidnych ram zarządzania AI: integracja aspektów prawnych, etycznych i operacyjnych

Wykraczając poza samą zgodność z przepisami, ustanowienie solidnych ram zarządzania AI jest niezbędne. Ramy te powinny jednoznacznie określać role i odpowiedzialności w zakresie nadzoru nad AI, wdrażać struktury odpowiedzialności oraz definiować wewnętrzne polityki zgodne zarówno z rygorystycznymi wymogami UE, jak i zróżnicowanymi wytycznymi amerykańskich agencji federalnych.

Kluczowe jest, aby ramy te uwzględniały zasady odpowiedzialnej AI, takie jak: odpowiedzialność, przejrzystość, sprawiedliwość i bezpieczeństwo. Aktualne dane wskazują, że wiele organizacji pozostaje w tyle pod względem wdrażania praktyk odpowiedzialnej AI na dużą skalę, co podkreśla pilną potrzebę opracowania takich rozwiązań.

Solidne ramy zarządzania AI, zwłaszcza takie, które integrują zasady etyczne, mogą stać się strategicznym wyróżnikiem. Budują zaufanie konsumentów i potencjalnie zmniejszają ryzyko przyszłej kontroli regulacyjnej, pokazując proaktywne zaangażowanie w rozwój odpowiedzialnej sztucznej inteligencji. Takie podejście proaktywne wzmacnia reputację marki i lojalność klientów, przynosząc bezpośrednie korzyści biznesowe.

Zapewnienie zgodności między jurysdykcjami: strategie zarządzania rozbieżnymi wymaganiami

Poruszanie się w globalnym labiryncie regulacji dotyczących AI wymaga strategicznego podejścia do zapewniania zgodności między różnymi jurysdykcjami. Kluczowa jest filozofia „compliance by design” – czyli wbudowanie mechanizmów kontroli ryzyka AI w cały cykl życia rozwoju systemu od samego początku, zamiast prób późniejszego dostosowywania rozwiązań do odmiennych regulacji. Takie podejście, choć wymaga inwestycji z góry, w dłuższej perspektywie zwiększa efektywność, zapewniając elastyczność w dostosowywaniu się do zmieniających się globalnych standardów. W praktyce pozwala to przekształcić wyzwanie regulacyjne w podstawową siłę operacyjną organizacji.

Organizacje powinny ustanowić scentralizowaną funkcję ds. zgodności AI, odpowiedzialną za monitorowanie globalnych zmian regulacyjnych, jednocześnie upoważniając lokalne zespoły do dostosowywania polityk i procedur do wymagań specyficznych dla danego państwa lub stanu. Ten model hybrydowy umożliwia spójną zgodność z nadrzędnymi zasadami, przy zachowaniu elastyczności wobec regionalnych różnic.

Kluczowe znaczenie ma również rygorystyczne zarządzanie dostawcami. Staranna analiza due diligence oraz solidne umowy o współpracy (BAAs – Business Associate Agreements) są niezbędne, zwłaszcza gdy zewnętrzne narzędzia AI przetwarzają dane wrażliwe. W takich przypadkach to organizacja wdrażająca AI może zostać pociągnięta do odpowiedzialności za naruszenia lub dyskryminację wynikającą z działań dostawcy.

Ograniczanie ryzyk prawnych, finansowych i reputacyjnych: działania proaktywne i reakcja na incydenty

Proaktywne inwestowanie w zarządzanie ryzykiem AI nie jest jedynie centrum kosztów – to strategiczna inwestycja, która bezpośrednio zmniejsza prawdopodobieństwo kosztownych batalii prawnych, wysokich kar finansowych i poważnych szkód wizerunkowych – czyli kwestii będących w centrum uwagi najwyższej kadry zarządzającej. Obejmuje to wdrażanie ciągłego monitoringu i regularnych audytów pod kątem uprzedzeń, dokładności, odporności i luk w zabezpieczeniach. Takie działania są kluczowe zarówno dla spełnienia wymogów UE dotyczących systemów wysokiego ryzyka, jak i dla ograniczania odpowiedzialności na gruncie amerykańskich przepisów antydyskryminacyjnych.

Co więcej, zapewnienie odpowiedniego nadzoru człowieka oraz mechanizmów „human-in-the-loop” ma zasadnicze znaczenie, aby zapobiegać ryzyku lub je minimalizować, a także umożliwiać ingerencję i unieważnianie decyzji AI, gdy jest to konieczne. Równie istotne są transparentność i jawność – należy jasno komunikować wykorzystanie AI osobom i interesariuszom, zgodnie z określonymi obowiązkami informacyjnymi (np. w przypadku chatbotów czy treści generowanych przez AI).

Na koniec, opracowanie solidnych planów reagowania na incydenty dostosowanych do naruszeń lub szkód związanych z AI – w tym wymogów szybkiego powiadamiania – jest niezbędne, aby ograniczyć i zminimalizować potencjalne szkody.

Budowanie kultury odpowiedzialnej AI: zaufanie i przewaga konkurencyjna

Wyjście poza samą zgodność z przepisami i rozwijanie autentycznej „kultury odpowiedzialnej AI” może przekształcić ciężar regulacyjny w przewagę konkurencyjną. Obejmuje to inwestowanie w programy edukacyjne i szkoleniowe z zakresu AI dla całego personelu – od zespołów technicznych po pracowników działów prawnych i klinicznych – aby zapewnić pełne zrozumienie wymogów prawnych, zasad etycznych i właściwego wykorzystania AI.

Tworzenie rad ds. etyki AI lub zespołów multidyscyplinarnych, które nadzorują etyczny rozwój i wdrażanie technologii, pozwala instytucjonalizować to zaangażowanie. Takie proaktywne podejście do odpowiedzialnej AI wzmacnia reputację marki, przyciąga najlepsze talenty oraz buduje głębsze zaufanie klientów i regulatorów na szybko zmieniającym się rynku, zapewniając długoterminowe korzyści strategiczne.

W tym kontekście zgodność z przepisami ewoluuje z obciążenia w wyróżnik budujący przewagę konkurencyjną.

Zakończenie: wyznaczanie kursu dla odpowiedzialnej AI w regulowanym świecie

Globalny krajobraz regulacyjny dotyczący sztucznej inteligencji jest bez wątpienia złożony – charakteryzuje się kompleksowymi, opartymi na prawach człowieka ramami UE oraz fragmentarycznym, lecz dynamicznie rozwijającym się podejściem USA. Takie środowisko wymaga od najwyższej kadry zarządzającej ciągłej czujności i strategicznego planowania. Proaktywne zaangażowanie w zarządzanie AI nie jest jedynie ćwiczeniem z zakresu zgodności z przepisami – to fundamentalny imperatyw biznesowy, który bezpośrednio wpływa na dostęp do rynków, stabilność finansową i reputację marki.

Choć obecnie występują istotne rozbieżności między modelami regulacyjnymi UE i USA, pojawiają się oznaki zbliżenia. Organizacje międzynarodowe, takie jak OECD, G7 i G20, opracowują wspólne zasady i standardy techniczne dla AI, koncentrujące się na takich pojęciach jak sprawiedliwość, przejrzystość i bezpieczeństwo. Również Rada ds. Handlu i Technologii UE–USA aktywnie pracuje nad wspólnymi definicjami i standardami.

Ta interakcja między globalnymi wysiłkami na rzecz harmonizacji a utrzymującymi się rozbieżnościami regionalnymi oznacza, że kadra zarządzająca najwyższego szczebla musi przyjąć strategię „dwutorową”. Obejmuje ona zarówno aktywne uczestnictwo w kształtowaniu i wpływaniu na globalne standardy tam, gdzie to możliwe, jak i równoczesne przygotowanie się na złożoną, wielojurysdykcyjną rzeczywistość zgodności regulacyjnej w przewidywalnej przyszłości.

W obliczu braku jednego, globalnego konsensusu firmy muszą być gotowe na dalszą fragmentację regulacyjną i wdrażać strategie „compliance by design”, aby sprawnie poruszać się wśród wielu, potencjalnie sprzecznych reżimów prawnych. Zdolność do odpowiedzialnego tworzenia, wdrażania i zarządzania systemami AI w tych zróżnicowanych środowiskach regulacyjnych będzie jedną z cech definiujących odnoszące sukcesy globalne przedsiębiorstwa nadchodzącej dekady.