W miarę jak sztuczna inteligencja (AI) staje się coraz bardziej zaawansowana, jej potencjalne implikacje dla biznesu stają się coraz bardziej zróżnicowane i złożone. Jedną z najważniejszych i ryzykownych kwestii do rozważenia jest to, jak zapewnić etyczny i odpowiedzialny rozwój AI. Niestety, wiele firm nie zwraca uwagi na etyczne implikacje AI, starając się wykorzystać tę transformującą technologię. Ten brak staranności może mieć katastrofalne skutki zarówno dla poszczególnych firm, jak i dla całej gospodarki. W tym artykule przeanalizujemy zagrożenia biznesowe wynikające z lekceważenia etyki w sztucznej inteligencji.

Ryzyko biznesowe związane z niską etyką i zarządzaniem SI

Rewolucja w dziedzinie sztucznej inteligencji (AI) jest w toku, a przedsiębiorstwa starają się w pośpiechu wdrażać technologie AI, aby zachować konkurencyjność. Jednak w miarę jak technologie AI stają się coraz bardziej wszechobecne i potężne, rośnie potrzeba rozważenia kwestii etycznych związanych z ich wykorzystaniem. Niestety, wiele firm nie radzi sobie w tej dziedzinie. W 2015 r. firma Amazon odkryła, że sztuczna inteligencja w jej oprogramowaniu rekrutacyjnym preferowała zatrudnianie kandydatów płci męskiej. Choć wywołało to poruszenie i wzbudziło zdziwienie w środowisku AI, te same błędy zdarzają się do dziś. Jesienią 2021 r. SI, która rekomenduje treści na Facebooku, polecała filmy o naczelnych użytkownikom, którzy oglądali film z brytyjskiego tabloidu z udziałem czarnoskórych mężczyzn.

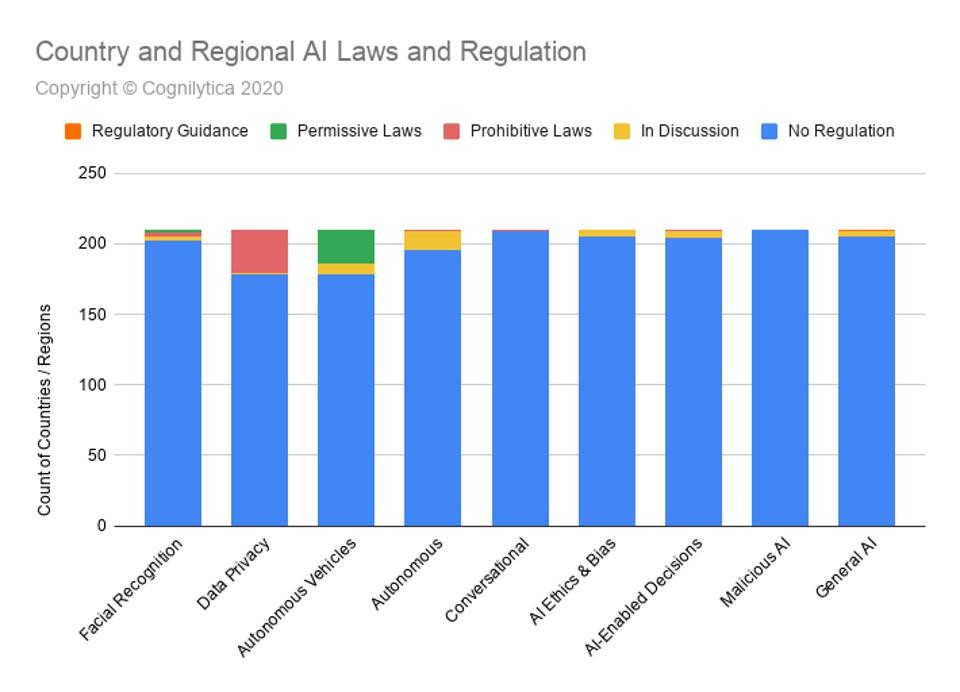

Jak wynika z powyższego wykresu, przepisy i regulacje dotyczące etyki i stronniczości AI są nadal przedmiotem dyskusji, pomimo niedociągnięć wielu firm technologicznych. Wykres ten pokazuje jednak również działania regulacyjne podjęte już w innych obszarach AI. Przepisy dotyczące etyki AI będą się rozwijać w miarę, jak AI będzie zyskiwać na znaczeniu i rozpowszechniać się w firmach na całym świecie. W związku z tym istnieje szereg zagrożeń związanych z ignorowaniem etyki w AI.

Działania regulacyjne

Po pierwsze, istnieje ryzyko działań regulacyjnych. W miarę upowszechniania się technologii AI rządy prawdopodobnie będą wprowadzać przepisy nadzorujące ich stosowanie. Jeśli firmy nie będą proaktywnie podchodzić do etycznych praktyk związanych z AI, mogą znaleźć się w niekorzystnej sytuacji konkurencyjnej. Według Harvard Business Review, Federalna Komisja Handlu (FTC) wydała nietypowo odważny zestaw wytycznych dotyczących „prawdy, uczciwości i sprawiedliwości” w AI – definiując nieuczciwość, a zatem nielegalne wykorzystanie AI, szeroko jako każde działanie, które „powoduje więcej szkody niż pożytku”. Wytyczne te są jeszcze na wczesnym etapie, ale sygnalizują nową erę regulacji rządowych dotyczących AI na całym świecie. Po wytycznych FTC z 2021 r. Komisja Europejska opublikowała swój własny zestaw zasad dotyczących sprawiedliwości i etyki w AI. Propozycja Komisji obejmuje wymóg, aby przedsiębiorstwa przeprowadzały „oceny wpływu” systemów AI, ze szczególnym uwzględnieniem kwestii równości i niedyskryminacji.

W nadchodzących latach presja regulacyjna będzie się zwiększać, w miarę jak technologie AI będą coraz bardziej zakorzenione w społeczeństwie. Przedsiębiorstwa, które nie podejmą proaktywnych działań w celu rozwiązania problemów etycznych związanych z AI, mogą znaleźć się w niekorzystnej sytuacji konkurencyjnej lub zostać ukarane grzywnami i karami.

Uszkodzenie reputacji

Po drugie, istnieje ryzyko utraty reputacji związane z nieetycznymi praktykami dotyczącymi sztucznej inteligencji. W ostatnich latach byliśmy świadkami, jak wiele znanych firm znalazło się pod ostrzałem z powodu wykorzystywania przez nie sztucznej inteligencji. W skandalu z Cambridge Analytica w 2015 r. Facebook wykorzystał chronione dane osobowe swoich użytkowników do celów reklamy politycznej. W wyniku tego incydentu Facebook stracił 35 miliardów dolarów wartości rynkowej i nadal jest platformą w dużej mierze niezaufaną przez amerykańską opinię publiczną. Jeśli firma zostanie przyłapana na wykorzystywaniu AI w sposób nieetyczny, może ponieść poważne szkody dla swojej reputacji.

Uszczerbek na reputacji może mieć znaczący wpływ na wyniki finansowe firmy. Badanie przeprowadzone przez Uniwersytet Kalifornijski w Berkeley wykazało, że cena akcji firmy spada średnio o 0,93% w dniu, w którym jest ona uwikłana w skandal. Ponadto w dłuższej perspektywie cena akcji tych firm spada o około 12%. Badanie wykazało również, że powrót do normalnego stanu po skandalu zajmuje średnio trzy lata. Ryzyko utraty reputacji związane z nieetycznymi praktykami sztucznej inteligencji jest po prostu zbyt duże, aby firmy mogły je zignorować.

Utrata przewagi konkurencyjnej

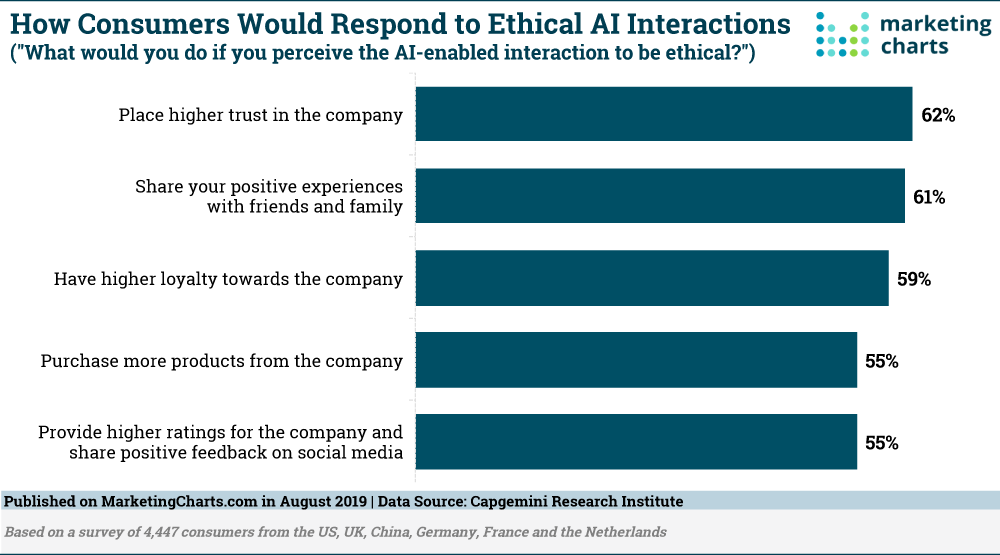

Po trzecie, istnieje ryzyko utraty przewagi konkurencyjnej. W miarę upowszechniania się technologii sztucznej inteligencji przedsiębiorstwa, które będą potrafiły skutecznie z nich korzystać, zyskają znaczną przewagę nad konkurentami. Jeśli jednak firma będzie postrzegana jako nieetyczna w korzystaniu z AI, może stracić przewagę konkurencyjną. Dzieje się tak dlatego, że klienci będą coraz częściej wybierać firmy, którym ufają, że korzystają z AI w sposób etyczny.

Z powyższego wykresu wynika, że konsumenci pozytywnie reagują na firmy, które wykorzystują sztuczną inteligencję w sposób etyczny. Dlatego firma może zwiększyć wskaźnik utrzymania klientów, rozważając etyczne implikacje wdrażanej przez siebie sztucznej inteligencji. W badaniu przeprowadzonym wśród 1000 konsumentów w Stanach Zjednoczonych, Wielkiej Brytanii i Niemczech 86% stwierdziło, że byliby skłonni zapłacić więcej za produkty i usługi firm, które stosują etyczne praktyki w zakresie sztucznej inteligencji. Ponadto 89% stwierdziło, że zbojkotowałoby daną firmę, gdyby okazało się, że wykorzystuje ona SI w sposób nieetyczny.

Jest oczywiste, że firmy muszą być świadome etycznych konsekwencji swoich praktyk związanych z AI. Ci, którzy tego nie robią, mogą znaleźć się w niekorzystnej sytuacji konkurencyjnej, narazić się na utratę reputacji lub nawet na regulacje rządowe.

Odpowiedzialność cywilna

Wreszcie, istnieje ryzyko odpowiedzialności cywilnej. Jeśli technologia sztucznej inteligencji stosowana przez firmę wyrządzi szkodę osobom fizycznym, firma może zostać pociągnięta do odpowiedzialności w procesie cywilnym. Jest to szczególnie istotne ryzyko, biorąc pod uwagę ostatnie postępy w technologii rozpoznawania twarzy. Jeśli firma wykorzysta technologię rozpoznawania twarzy w sposób nieetyczny, może zostać pozwana za naruszenie prywatności lub zniesławienie.

Zaczynają się już pojawiać przypadki odpowiedzialności cywilnej. W maju 2017 r. pewna kobieta w Stanach Zjednoczonych złożyła pozew przeciwko Facebookowi po tym, jak oprogramowanie firmy do rozpoznawania twarzy błędnie zidentyfikowało ją jako terrorystkę. W wyniku błędu kobieta, która jest pochodzenia bliskowschodniego, została zatrzymana przez FBI. Co więcej, Google ma obecnie do czynienia z pozwem zbiorowym w Wielkiej Brytanii w związku z naruszeniem danych dotyczących zdrowia, które złamało tamtejsze prawo o ochronie danych. System sztucznej inteligencji DeepMind firmy Google wykorzystał informacje zdrowotne milionów pacjentów w aplikacji bez ich zgody. Przypadki takie jak ten będą prawdopodobnie coraz częstsze w miarę upowszechniania się technologii sztucznej inteligencji. Przedsiębiorstwa muszą być świadome możliwości poniesienia odpowiedzialności cywilnej i podjąć kroki w celu ograniczenia tego ryzyka.

Wnioski

To tylko kilka przykładów ryzyka biznesowego związanego z niską etyką i zarządzaniem SI. Firmy, które chcą pozostać w czołówce, muszą upewnić się, że traktują te zagrożenia poważnie.

Rewolucja w dziedzinie sztucznej inteligencji (AI) jest w toku, a przedsiębiorstwa starają się w pośpiechu wdrażać technologie AI, aby zachować konkurencyjność. Jednak w miarę jak technologie AI stają się coraz bardziej wszechobecne, rosną obawy o etyczne implikacje ich stosowania. Przedsiębiorstwa, które proaktywnie nie rozwiążą tych problemów, mogą być narażone na poważne ryzyko, w tym na działania organów regulacyjnych, utratę reputacji, utratę przewagi konkurencyjnej i odpowiedzialność cywilną.

Źródła:

Czytaj więcej: Sztuczna inteligencja pomaga odtworzyć umiejętności rdzennych tropicieli i ochronić zagrożone gatunki